在資料工程師的工作中,很常需要使用到開源工具來解決問題,像是 Apache Airflow 或 FastAPI 都是可商用且已經被泛用的開源工具,但我們該如何評估一個新的開源專案值不值得使用或研究呢? 這篇文章我整理了網友和我自己的經驗,以 GitHub 為例,分享有哪些重點是我們在選擇 Open Source 時可以納入考慮的。

最優先要考慮的是需求

我認為所有的考量都要以需求出發,思考這個開源工具是否真的能解決目前遇到的問題,或是達成使用者提出的需求,並且這個工具的規範在公司內是合法合規的,都確認後才能繼續往下探討其他指標。

其他指標我目前把他們分成幾大類:

- 功能性

- 文件完整性

- 維護活躍度

- 社群支持度

- 程式碼品質與穩定性

- 安全性

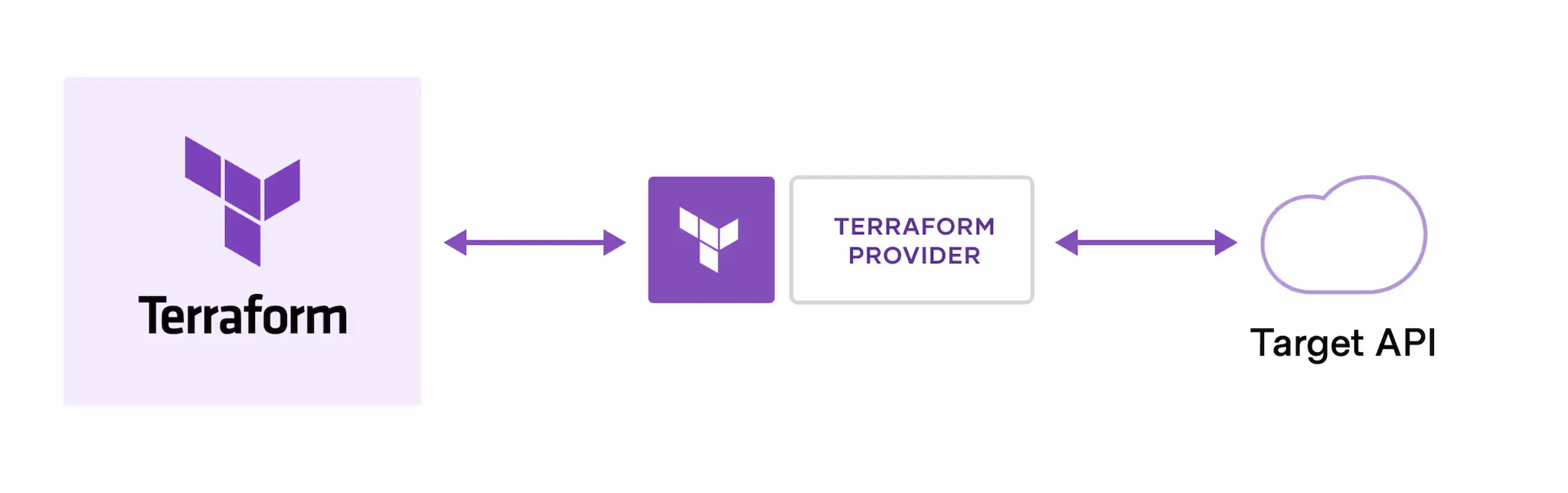

- 相依相容性

開源專案的參考指標

1. 功能性

- 功能完整性: 工具的功能是否完整且穩定?是否缺少關鍵功能?

- 易用性:

- 這個工具是否容易安裝、設定和使用?是否有清晰的 API 或介面?

- 是否可用

pip install安裝? - 是否提供 Dockerfile / Docker Compose 的方式來部署?

- 效能:

- 工具的效能是否能處理你的資料量和運算量?是否有相關的效能測試報告?

- 這個工具在 ELT、分析、視覺化或建模方面的能力如何?