前言

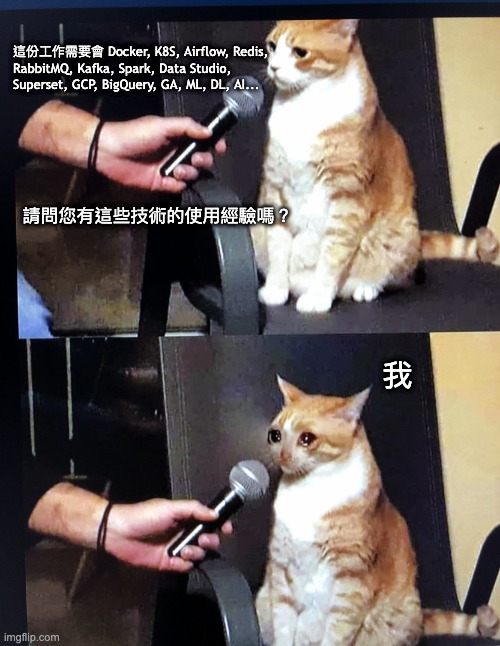

近期因為轉換工作面試了不少公司的資料工程師

面試流程不外乎就是「自介」+「考試」+「問問題」

在問問題的環節經常被問到會不會使用某些工具

以下大概整理一下我面試 Data Engineer 最常被問到的幾項技術

最常被問到的

![]() Docker (容器化)

Docker (容器化)

![]() K8S (CI/CD)

K8S (CI/CD)

![]() Airflow (排程自動化)

Airflow (排程自動化)

覺得這三項已經完全是基本款要會的了

幾乎每一間公司都會用到

部分公司也有問到

![]() Redis (Cache 資料庫)

Redis (Cache 資料庫)

![]() RabbitMQ (Message Queue)

RabbitMQ (Message Queue)

![]() Kafka (Streaming Data)

Kafka (Streaming Data)

![]() Spark (分散式架構)

Spark (分散式架構)

視覺化工具

視覺化工具

- 現在 Data Studio 越來越多公司在使用

- Tableau 也還是滿多的

- 另外部分公司會使用 Superset

- 反而我比較熟悉的 Metabase 相較冷門,甚至有的公司連聽都沒聽過

雲端

雲端

- 主要我遇到的公司大多都是使用 GCP (搭配 BigQuery)

- 另外一部分則是 AWS

其他

其他

- 若是數位媒體或廣告相關的產業可能就必備 Google Analytics 相關的經驗

- 很多公司的資料工程師也會碰到 Machine Learning 相關的工作內容,所以熟悉 Scikit-Learn 或 TensorFlow 也會很加分

結語

其實還有很多技術我這邊沒有寫出來的

我覺得「樂於學習新事物」是加入資料科學領域的重要特質之一

Data 相關的技術和演算法發展的速度真的好驚人啊~

最近在 Medium 看到有人整理了 80 個左右的資料工程技術(文章在這)

有興趣的人可以參考看看自己知道或是用過幾個

也可以追蹤我的 FB 粉專:JumpingCode 資料科學手記